ChatGPT – Avancées et défis éthiques de l’Intelligence Artificielle Générative

Introduction : ChatGPT, le nouvel incontournable

En novembre 2022, ChatGPT-3 a révolutionné le domaine de l’intelligence artificielle en tant que chatbot (agent conversationnel) basé sur une IA générative. Développé par OpenAI, une entreprise spécialisée dans les avancées technologiques en IA, ChatGPT a repoussé les frontières des grands modèles de langage (Large Language Models, ou LLM) par sa capacité remarquable à comprendre et à générer du langage naturel tout en prenant en compte le contexte interactif de l’utilisateur.

En plus de son interface conversationnelle, encourageant au dialogue avec la machine, sa disponibilité et sa gratuité pour tous ont participé à son caractère innovant. Alors que les technologies similaires étaient auparavant réservées aux grandes entreprises, OpenAI a ouvert ChatGPT au grand public, malgré le coût phénoménal engendré, estimé en février 2023 à près de 700 000 $ quotidiens. L’engouement autour de l’outil fut colossal : il atteint son millionième utilisateur 5 jours après sa sortie, et un pic de 1.8 milliard de visites en mai 2023. Depuis, une pléthore d’acteurs a emboité le pas d’OpenAI en diffusant des chatbots généralistes, spécialisés, humoristiques, etc. : on peut citer Copilot de Microsoft (basé sur ChatGPT), Bard / Gemini de Google, MyAI de Snap Inc., Grok de X (ex-Twitter), …

La vitesse d’adoption et la popularité de ces outils a également alimenté de nombreuses discussions et débats : l’Intelligence Artificielle fit irruption dans le débat public et depuis lors, s’est imposée comme un sujet central de l’actualité.

S’il ne fait aucun doute que l’Intelligence Artificielle peut offrir de nombreuses opportunités et applications, cet outil n’est pas sans risques ni limites. Il existe des biais et défis éthiques liés au développement et à l’utilisation des outils d’IA, notamment générative, qui doivent être pris en compte et débattus.

ACI partners, comme bien d’autres acteurs, a pris à bras le corps cette nouvelle donne du paysage informatique et professionnel : Nous avons produit notre charte interne d’utilisation de l’Intelligence Artificielle, et dans cet article nous nous proposons de présenter notre point de vue sur ces questions, ainsi que nos pistes de réflexion pour favoriser une intelligence artificielle responsable et équitable.

I. Les biais et limites inhérents à l’IA générative

Bien que ChatGPT ait apporté des avancées significatives dans le domaine de l’intelligence artificielle, il présente certains biais et limites à mettre en évidence.

- Ces biais qui sont inhérents au fonctionnement des IA génératives. Ils peuvent provenir des données d’apprentissage, des modèles utilisés, du contexte d’utilisation voire des interactions avec les utilisateurs.

- La disponibilité des données d’entrainement va par exemple fortement impacter les réponses produites. Que ce soit pour la langue utilisée ou les sujets abordés, des données d’entrainement fiables sont nécessaires.

- Parfois, des biais de discrimination raciaux ou de genre peuvent être reproduits à partir des données d’entraînement, même sans constituer des contenus explicitement offensants, ce qui peut échapper aux filtres de l’algorithme.

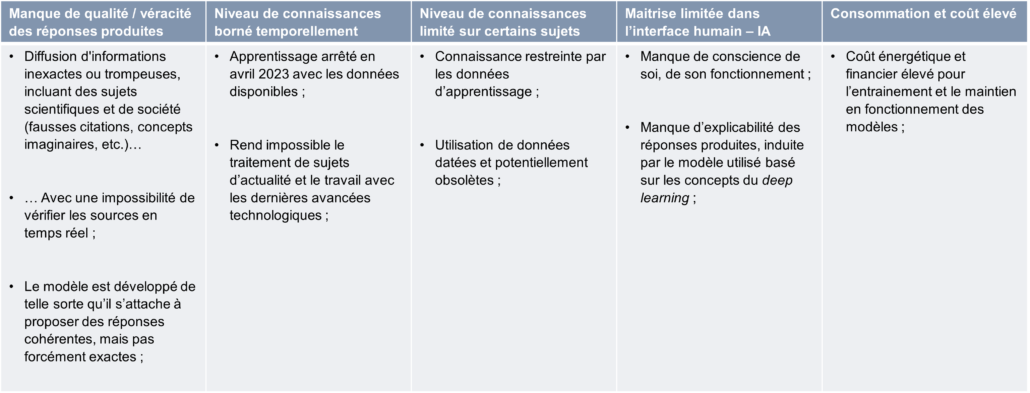

Au-delà des biais, il existe également des limites importantes, particulièrement pour ChatGPT. Ces limites doivent être prises en considération lors de son utilisation.

Certaines de ces limitations sont particulièrement problématiques lorsque l’exactitude des réponses est cruciale, notamment dans les domaines de la finance, du droit, ou bien celui du conseil. Dans ces cas, il est impératif de recourir à d’autres sources d’information plus fiables et vérifiées et de ne jamais s’appuyer uniquement sur les réponses d’un modèle.

Il est aussi important de noter que ChatGPT, et les futures IA génératives présentent des risques en termes de confidentialité des données personnelles des utilisateurs et du contenu des conversations obtenus. Afin de minimiser les risques liés à la divulgation d’informations sensibles, le partage d’informations confidentielles avec ces modèles est donc à éviter voire à bannir.

II. Préoccupations éthiques et environnementales liées aux LLM

L’entraînement de ChatGPT a également suscité son lot de préoccupations. Le Time a notamment révélé qu’OpenAI avait fait appel à des sous-traitants employant des travailleurs Kenyans pour classer des textes aux contenus sensibles (ayant des propos sexistes, racistes, etc…), le tout pour un salaire de moins de 2$ de l’heure. Cela pose la question des conditions de travail et de la rémunération équitable des employés.

D’autre part, l’entraînement même du modèle de ChatGPT nécessite de grandes quantités d’électricité, générant un impact environnemental important. Malgré les défis posés par la consommation énergétique, OpenAI continue de répondre à la demande croissante en utilisant d’importantes ressources pour alimenter ses modèles, ce qui soulève des interrogations sur la durabilité des IA à grande échelle.

III. Les risques de détournements et usages malveillants

Des IA génératives, dont ChatGPT, sont d’ores et déjà exploitées à des fins malveillantes.

On les retrouve dans la personnalisation de spams. On s’en sert pour générer des e-mails trompeurs, spécifiquement adaptés à chaque destinataire, rendant ainsi le spam plus difficile à détecter par les filtres en place sur les boites mail, et augmentant les chances d’ouverture.

Également, certains sites web et auteurs les utilisent pour générer des articles ou réécrire du contenu qui sera ensuite utilisé comme contenu publicitaire. Tout en contribuant à la baisse de la qualité du contenu en ligne, ces pratiques questionnent sur l’éthique et la fiabilité de l’information.

IV. De nombreux enjeux réglementaires à adresser

Le développement rapide des IA génératives dont ChatGPT soulève un certain nombre de questionnements d’ordre réglementaire :

- Protection des données personnelles : La question de la protection des données à caractère personnel est encadrée en Europe par la RGPD (Règlement Général sur la Protection des Données), et implique les différents acteurs de l’exploitation de ce type de données, OpenAI ne faisant pas exception. Depuis le lancement de ChatGPT, plusieurs plaintes ont été déposées auprès de la CNIL (Commission Nationale de l’Informatique et des Libertés), en lien avec la politique de confidentialité, le manque de transparence quant à la l’utilisation des données personnelles pour l’apprentissage, ou encore la publication d’informations erronées sur des personnes. Ces plaintes ont abouti à l’ouverture d’une enquête par la CNIL.

- Propriété intellectuelle : ChatGPT peut générer des textes qui sont des agrégations de multiples sources, sans en citer les auteurs, et sans informations sur la propriété de ces sources. De fait, la propriété intellectuelle entourant ses créations reste floue. ChatGPT n’est pas considéré comme un auteur. Que se passe-t-il donc en cas d’exploitation de ses créations par un utilisateur ? L’utilisateur est-il propriétaire de la publication ? Ce sont des questionnements qui restent à adresser, et qui posent également la question de la responsabilité engagée par la production de contenus.

- Engagement de la responsabilité civile : La question se pose dans les métiers du conseil notamment, où les livrables créés sont utilisés pour la prise de décision dans de grands groupes, avec de forts enjeux réglementaires et financiers. Dans le cas de l’utilisation de ChatGPT, qu’en est-il de la responsabilité des contenus générés par l’outil ? La réponse est donnée dans les conditions d’utilisation (Disclaimer of Warranties), fournies par OpenAI : la vérification des informations fournies et la conformité aux lois en vigueur incombe à l’utilisateur, et en aucun cas à OpenAI.

Ces différents points, qu’ils soient identifiés de longue date ou inédits, nécessitent une mise à jour régulière des dispositifs d’encadrement de la part du régulateur. Au niveau européen, plusieurs réglementations sont mises en œuvre :

- L’Artificial Intelligence Act (AI Act), depuis avril 2021

- La Directive relative à l’adaptation des règles en matière de responsabilité civile extracontractuelle au domaine de l’IA, depuis septembre 2022

- Un plan d’action de la CNIL déployé en 2023 en lien avec le développement rapide des IA génératives, et décliné en 4 grands volets :

- Appréhender le fonctionnement des systèmes d’IA et leurs impacts pour les personnes

- Permettre et encadrer le développement d’IA respectueuses de la vie privée

- Fédérer et accompagner les acteurs innovants de l’écosystème IA en France et en Europe

- Auditer et contrôler les systèmes d’IA et protéger les personnes

Conclusion : un appel à la responsabilité et à la fiabilité

En conclusion, il est indéniable que ChatGPT représente une grande avancée dans le domaine des IA génératives, ouvrant de nouvelles perspectives dans divers domaines d’application. Cependant, malgré ses performances impressionnantes, cet outil présente des limites importantes et des préoccupations éthiques, environnementales et légales. Les biais issus des données d’entraînement, l’efficacité limitée dans certaines langues, et la publication de fausses informations soulèvent des interrogations sur l’exactitude et la fiabilité des réponses fournies. Face à ces enjeux, il est essentiel de considérer ces limites et de s’appuyer sur des sources d’information plus fiables lorsque l’on travaille avec ces nouvelles technologies. De plus, l’entraînement du modèle de ChatGPT a suscité des inquiétudes concernant les conditions de travail et la rémunération équitable des employés, ainsi que son impact environnemental important.

D’autres acteurs majeurs de l’industrie de l’IA tels que Meta ou encore Google se sont également lancés dans la publication de leurs propres modèles de langage (avec LLaMA 2 et PaLM-2), contribuant à l’avancement du domaine des agents conversationnels. Dans un objectif de développement responsable et durable des outils utilisant des modèles d’IA génératives, il est impératif de considérer les limites et les implications éthiques de ces technologies.